Les intelligences artificielles (IA) promettent l’accès rapide et simplifié à une quantité de données rendues opérantes grâce à des modèles performants. À quel point ces nouveaux outils, qui facilitent le processus de décision publique, peuvent-ils aussi le biaiser à l’insu du décideur ? Que cache la conception des IA ? Comment dépasser leurs biais ?

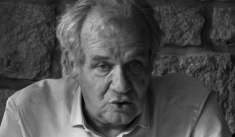

Lors de l’édition 2024 de Numérique en Commun[s] à Chambéry (voir encadré), une table ronde a été consacrée aux enjeux éthiques propres à la façon dont les IA sont pensées, fabriquées et déployées. Animée par le journaliste Xavier de la Porte, elle a permis de décortiquer la donnée comme matériau fondamental de l’IA, en croisant l’expertise de quatre intervenants : Maryse Carmes, Mathilde Bras, Benjamin Guedj et Hubert Guillaud.

Des bases de données surdimensionnées pour des traitements énergivores

La conception des intelligences artificielles génératives (IAG) repose sur des «…

Cet article est réservé aux abonnés.

OU

Abonnez-vous à la revue Horizons publics

-

Formule Intégrale Pro

6 numéros par an

+ 4 hors-séries

+ 10 comptes d'accès au site

-

Formule Intégrale Perso

6 numéros par an

+ 4 hors-séries

+ 1 compte d'accès au site

S'abonner